Perceptron: a mesterséges neurális hálózatok alapköve

A mesterséges intelligencia fejlődéstörténetében kevés olyan fogalom létezik, amely akkora hatással bírt, mint a perceptron. Ez a modell, amelyet az 1950-es évek végén Frank Rosenblatt dolgozott ki, nem csupán egy új matematikai eszköz volt, hanem egy egész kutatási irányzat katalizátora. A perceptron megjelenése tette először kézzelfoghatóvá azt az elképzelést, hogy egy gép képes lehet az emberi agy neuronjainak működését utánzó struktúrákon keresztül tanulni és döntéseket hozni.

Ebben a cikkben részletesen bemutatom a perceptron fogalmát, történeti hátterét, Rosenblatt szerepét és az általa nyitott új kutatási lehetőségeket. Kitérünk arra is, hogyan kapcsolódott a perceptron az ún. „MI-télhez” (az AI fejlődésének megtorpanásához), majd áttekintjük, miként vezettek a többrétegű perceptronok és a visszaterjesztés (backpropagation) algoritmus új korszakhoz a 20. század végén. Végül megmutatom azt is, miért számít a perceptron a modern mélytanulás alapjának, és gyakorlati példákon keresztül szemléltetem működését

A perceptron születése és Frank Rosenblatt munkássága

A perceptron ötletét Frank Rosenblatt pszichológus és mérnök vetette papírra 1957-ben, amikor a Cornell Egyetemen dolgozott. Rosenblatt célja az volt, hogy olyan matematikai modellt hozzon létre, amely képes az emberi agy neuronjainak legegyszerűbb működését utánozni. A modell alapgondolata, hogy a „neurális egység” (a perceptron) bemeneteket fogad, azokat súlyokkal szorozza meg, majd egy összegzési függvény alapján döntést hoz: aktiválódik (1) vagy nem aktiválódik (0).

Rosenblatt nem állt meg az elméletnél: megépítette az első hardveres perceptron-prototípust, a Mark I Perceptront (1958), amely optikai szenzorokból, relékből és motorokból állt. Ez a szerkezet képes volt egyszerű mintafelismerésre – például betűk és alakzatok azonosítására –, és szenzációt keltett a korabeli sajtóban. A New York Times például azt írta, hogy a perceptron „egyszer talán képes lesz járni, beszélni, látni, írni és tudatosítani a létezését” – noha ez a jóslat kissé túlzó volt, jól mutatta, mekkora reményeket fűztek a technológiához.

Hogyan működik a perceptron?

A perceptron működésének lényege néhány egyszerű lépésben írható le:

Bemeneti adatok: a perceptron különböző jellemzőket (pl. képpontértékeket, szavakat, mérési adatokat) kap bemenetként.

Súlyozás: minden bemenethez egy súly tartozik, amely azt mutatja meg, mennyire fontos az adott jellemző a döntéshez.

Összegzés: a bemenetek és súlyok szorzatait a perceptron összeadja.

Aktivációs függvény: az összeg egy küszöbértékhez (threshold) hasonlíttatik. Ha az összeg nagyobb a küszöbnél, a perceptron „tüzel” (1), különben nem (0).

Ez a folyamat egyszerű bináris döntést eredményez, például: ez egy macska (1), vagy nem macska (0).

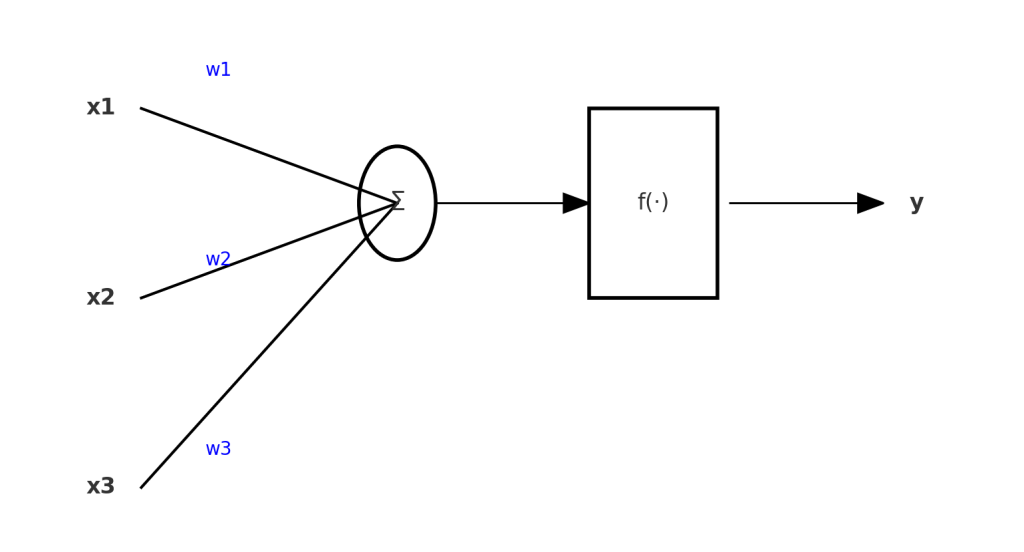

Ábra – A perceptron működési modellje

x1 —- w1 \

x2 —- w2 >—- Σ —-> f(·) —-> y

x3 —- w3 /

(összegzés + aktivációs függvény)

- xi = bemenetek

- wi = súlyok

- Σ = súlyozott összegzés

- f(·) = aktivációs függvény

- y = kimenet

Ez az egyszerű szerkezet lett a neurális hálózatok építőköve.

A perceptron modell működése.

A perceptron jelentősége és hatása

A perceptron bemutatása mérföldkő volt, mert:

Formális modell: először adott szigorú matematikai keretet annak, hogyan utánozható a neurális működés.

Tanulási képesség: Rosenblatt algoritmusa lehetővé tette, hogy a perceptron a bemeneti adatok és a kívánt kimenetek alapján „tanulja” a súlyokat.

Mintafelismerés: bebizonyította, hogy gépek képesek lehetnek képi és szöveges adatokból egyszerű szabályokat felismerni.

A perceptron tehát nem pusztán elmélet volt, hanem az első valóban működőképes gépi tanulási modell.

A perceptron és az MI-tél: Minsky és Papert kritikája

Bár Rosenblatt perceptronja ígéretesnek tűnt, hamarosan komoly kritikát kapott. Marvin Minsky és Seymour Papert 1969-ben kiadott könyvükben (Perceptrons) rámutattak a modell súlyos korlátaira:

- Az egyrétegű perceptron nem képes megoldani nemlineárisan elválasztható problémákat, például a klasszikus XOR-problémát.

- A perceptron csak nagyon egyszerű döntési határokat tudott megtanulni.

Ez a kritika odáig vezetett, hogy az MI-kutatások finanszírozása sok helyen visszaesett, és beállt az ún. „MI-tél”: egy több évtizedes stagnálás, amikor a perceptronokat és a neurális hálózatokat zsákutcának tekintették.

A többrétegű perceptronok és az újjászületés

Az 1980-as években azonban új remény ébredt. Kutatók, köztük Geoffrey Hinton, kimutatták, hogy ha több perceptront rétegekbe szervezünk, a hálózat képes összetett, nemlineáris problémák megoldására is. Ezek lettek a többrétegű perceptronok (MLP – Multi-Layer Perceptrons).

A döntő áttörést a visszaterjesztés (backpropagation) algoritmus adta, amely lehetővé tette a rétegek közötti súlyok hatékony tanulását. Ezáltal a neurális hálók már képesek lettek bonyolult minták (pl. beszéd, képfelismerés) feldolgozására.

A többrétegű perceptronok így megoldást adtak arra a problémára, amely az egyrétegű perceptront zsákutcába vitte, és ezzel újraindították a mesterséges intelligencia fejlődését.

A perceptron öröksége: a mélytanulás alapjai

A perceptron ma már önmagában elavult modellnek számít, mégis minden modern neurális hálózat gyökere hozzá vezethető vissza.

Az egyrétegű perceptron az alapokat teremtette meg: hogyan lehet bemenetekből súlyozott döntést hozni.

A többrétegű perceptron megmutatta, hogy rétegezett szerkezetek képesek komplex problémák megoldására.

A mély neurális hálózatok (Deep Learning) pedig gyakorlatilag ennek a gondolatnak a kiterjesztése, sok száz vagy ezer réteggel, hatalmas adatmennyiségeken.

Ma a perceptron elméleti leszármazottai működnek a képfelismerő rendszerekben (pl. önvezető autók), a beszédfelismerésben (pl. digitális asszisztensek), a gépi fordításban vagy épp a generatív MI-ben.

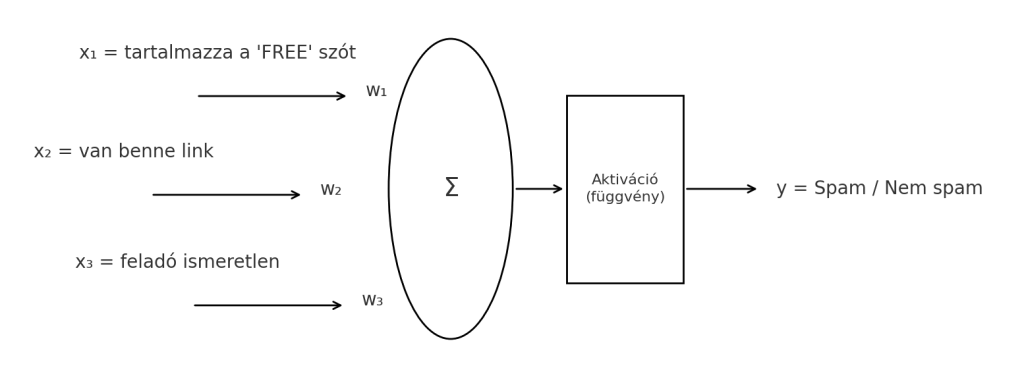

Példa a perceptron alkalmazására

Képzeljük el, hogy egy perceptronnal azt szeretnénk eldönteni, hogy egy e-mail spam-e vagy sem.

Bemenetek: szavak gyakorisága, speciális kifejezések (pl. „ingyen”, „nyeremény”), linkek száma.

Súlyozás: ha a levél sok gyanús szót tartalmaz, a súlyozott összeg nagyobb lesz.

Küszöbérték: ha a pontszám átlépi a küszöböt, a perceptron spamnek jelöli az e-mailt.

Ez egy rendkívül egyszerű példa, de jól mutatja, hogyan képes a perceptron gyakorlati döntések meghozatalára.

A perceptron modell működése a gyakorlatban.

Külső források és további olvasmányok

Professor’s perceptron paved the way for AI – 60 years too soon — Cornell University News (2019), Frank Rosenblatt és a perceptron története bemutatása. news.cornell.edu

CS229 Lecture Notes – Andrew Ng & Tengyu Ma (2023) — „Digression: the perceptron learning algorithm” szakasz, a perceptron tanulási algoritmusának leírása. cs229.stanford.edu

The Perceptron: A Perceiving and Recognizing Automaton — Frank Rosenblatt (1957), Rosenblatt eredeti tanulmánya. bpb-us-e2.wpmucdn.com

Geoffrey Hinton: A perceptron újrafelfedezése

Perceptrons könyv (Minsky & Papert, 1969)

Michael Nielsen: Neural Networks and Deep Learning (online könyv)

One thought on “Perceptron: az egyszerűsített mesterséges intelligencia alapja.”

Nagyon köszönjük a kiváló összefoglalót. Biztos vagyok benne, hogy sokaknak ad kitűnő támpontot a mesterséges intelligencia működésének megértéséhez.